Ostatnio pisałem o tym, jak AI może stać się naszym najpotężniejszym sojusznikiem, pomnażając produktywność. Dziś pora na drugą stronę medalu – historię o tym, jak ten sam turbodopalacz, może przepalić nam sporo czasu…

🎯 Cel: Wykorzystać wsparcie AI w tworzeniu nowego projektu Python

Pracując nad nową aplikacją – tym razem wracam do Python, chciałem (mocniej niż do tej pory) oprzeć się na pomocy AI. Wszystko szło gładko, kod powstawał w ekspresowym tempie… aż do momentu, gdy trafiłem na naprawdę uparty błąd.

🛣️ Droga: Ściana, ślepy zaułek i… uparta AI

Zgubiłem czujność. Skoro do tej pory wszystko szło tak płynnie, założyłem, że AI szybko znajdzie rozwiązanie. I tu zaczął się problem… 🤦♂️

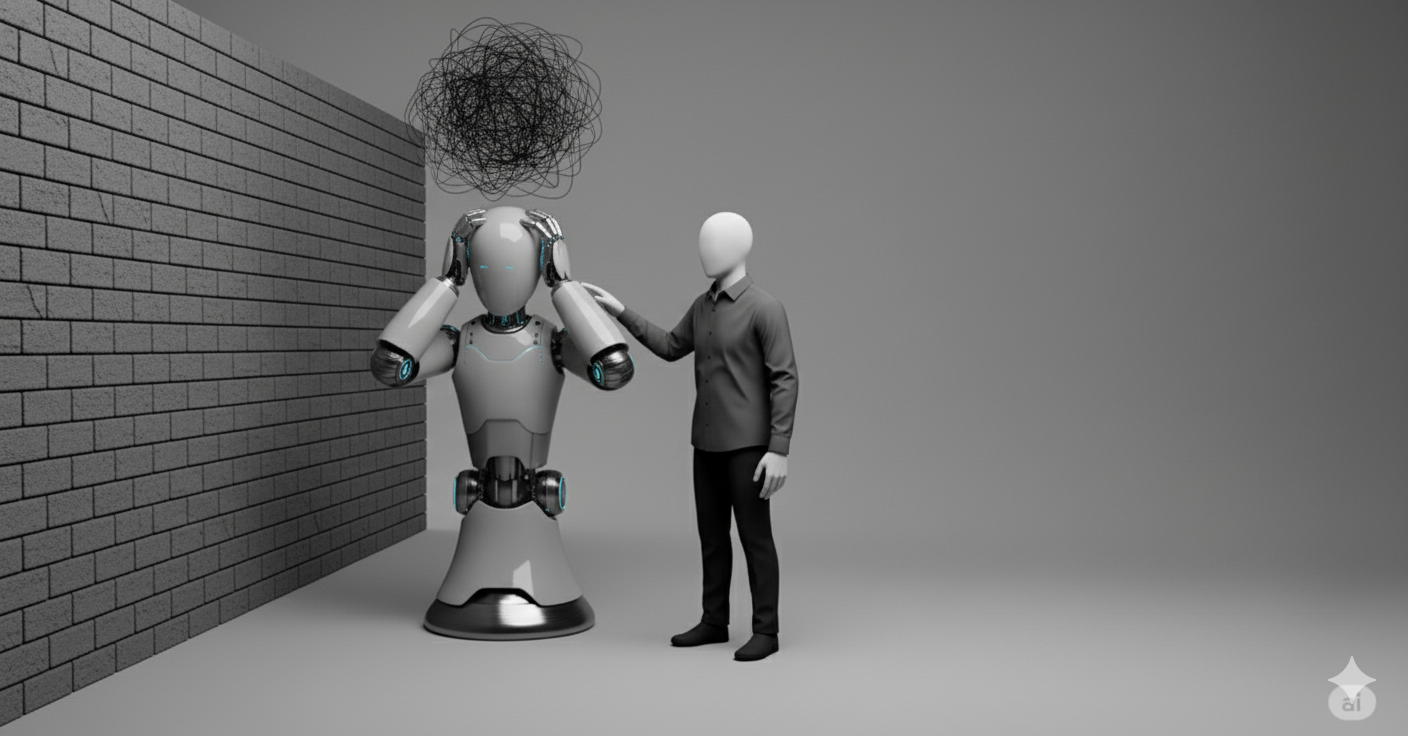

Zarówno GPT-5, Gemini 2.5 Pro, jak i Claude Sonnet 4 dochodziły do tej samej ściany. Każdy z modeli uparcie twierdził, że błąd leży w jednym, konkretnym fragmencie kodu. Poprawiałem go zgodnie z sugestiami, ale to nic nie dawało. Co gorsza, AI wpadło w pętlę – w pewnym momencie w kółko sugerowało modyfikacje tej samej metody, nawet gdy sugerowałem, że przyczyna „chyba” leży gdzieś indziej. Mimo dostarczania pełnego kontekstu, dokumentacji, screenshotów i otwierania nowych konwersacji asystenci w końcu dochodzili do tego samego miejsca i kurczowo trzymali się swojej wersji.

Zmarnowałem tak 3 czy 4 godziny, czując powoli rosnącą frustrację…

✅ Wynik: Kawa, dystans i 30 minut skupienia

W końcu coś mnie wybiło z transu… odszedłem od komputera. Zrobiłem sobie przerwę i kawę. Na spokojnie, bez żadnej pomocy totalnie zagubionych “chłopaków”, zacząłem analizować kod krok po kroku. Po około 20 minutach znalazłem błąd – był w zupełnie innym miejscu niż sugerowały modele, a ja w parę minut poprawiłem linijkę, która go spowodowała.

Ta sytuacja to dla mnie kubeł zimnej wody i mocne zderzenie ze ścianą. Mimo tego, że dobrze znam ograniczenia AI, pracuje z tym na co dzień nie tylko kodując – rozpędziłem się i dałem się złapać w pułapkę „flow”. Ślepo zaufałem narzędziu, które miało mnie tylko wesprzeć…

Dodam, że błąd nie był typowym „błędem” – z nimi AI radzi sobie wspaniale. Była to natomiast funkcjonalność, która działała, ale nie tak, jak powinna. Błąd nie pojawiał się w konsoli, aplikacja uruchamiała się bez problemów i właśnie tu widać jak modele „wariują” najbardziej.

Morał? AI to genialny turbodopalacz, ale to my trzymamy kierownicę. Oddanie jej w 100% to prosta droga do straconego czasu (i frustracji). 🤷♂️

A jak Wy sobie radzicie, gdy AI uparcie trzyma się błędnej tezy, albo całkowicie się pogubi? Macie jakieś sprawdzone tipy na takie sytuacje? Podzielcie się w komentarzach! 👇😉